対話型AI「ChatGPT」が生成した「患者への回答」は人間の医師による回答より好まれることが研究で判明

以下は、記事の抜粋です。

OpenAIが開発した対話型AIのChatGPTは、アメリカの医師免許試験であるUnited States Medical Licensing Exam(USMLE)に合格できるという研究結果も報告されるほど精度の高い文章を生成することが可能であり、さまざまな分野での応用が期待されています。

新たにカリフォルニア大学サンディエゴ校の研究チームが行った研究では、ChatGPTが生成した「患者へのアドバイス」と人間の医師によるアドバイスを専門家が比較した結果、ChatGPTのアドバイスの方が高い評価を得られることがわかりました。

研究チームは、「AskDocs」というフォーラムに目を向けました。AskDocsでは患者からの質問に対し、モデレーターによって身元が検証された医師が回答するというフォーラムであり、膨大な数の質問と回答が行われています。

研究チームはAskDocsから195件の質問と回答をランダムに収集し、元の質問をChatGPTに与えて回答を生成させました。そして3人の医療専門家に対し、寄せられた質問とChatGPTによる回答および医師による回答を評価してもらいました。回答を評価した医療専門家には、それぞれの回答がChatGPTによるものか人間の医師によるものかは開示されなかったとのことです。

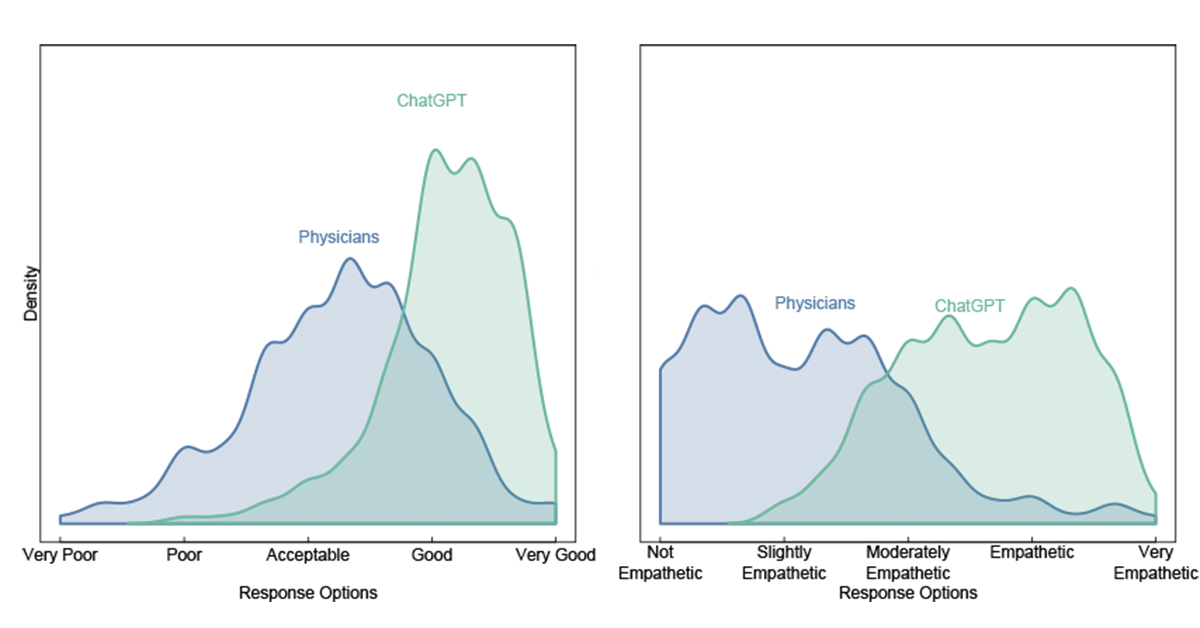

実験の結果、医療専門家らは78.6%の割合で人間の医師による回答よりもChatGPTの回答を好み、「質が高い」と評価される回答の割合もChatGPTの方が約3.6倍も高いことがわかりました。さらに、患者の質問に対して「共感的」「非常に共感的」と評価される回答の割合は、人間の医師の場合は4.6%だったのに対し、ChatGPTの場合は45.1%に達しました。

研究チームによると、ChatGPTの回答は人間の医師による回答よりも文章量が多く、この点が回答に対する高評価につながった可能性があるとのこと。論文の共著者のJessica Kelley氏は、「ChatGPTのメッセージはニュアンスのある正確な情報で応答し、患者の質問に対して医師の回答よりも多くの側面に対応することが多くありました」と述べています。

元論文のタイトルは、”Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions Posted to a Public Social Media Forum(公共のソーシャル メディア フォーラムに投稿された患者の質問に対する医師と人工知能チャットボットの応答の比較)”です(論文をみる)。

記事にも書かれていますが、医師がChatGPTを活用することで、より良い共感的なケアを行うことができると思いました。

以下は、論文に掲載されている図です。圧倒的な結果であることがわかります。

独立したライセンスを持つ医療従事者が、患者さんの質問に対するChatGPTと医師の回答の質(左)と共感度(右)の両方を評価したところ、79%の確率でChatGPTの回答が好ましいと回答しています。

コメント