「ChatGPT」は論文著者になれない、医学誌編集者団体が声明

最近話題のChatGPTについて、医学誌編者団体が声明を出しました(声明をみる)。ChatGPTの評価として参考になると思います。以下は、記事の抜粋です(下線はブログ著者)。

2022年11月にリリースされた米国OpenAIが開発した「ChatGPT」が話題を集めている。質問文を入力するとAIが次々に回答を提示してくれるこの種のサービスは、Webから広範なデータを収集し、強化学習させた回答が提示される。

92ヵ国・1,000以上のジャーナルを代表する2,000人近い医学誌編集者が所属して構成される「WAME:World Association of Medical Editors」は、論文執筆におけるChatGPTの利用に関して

2023年1月21日付の声明を発表した。

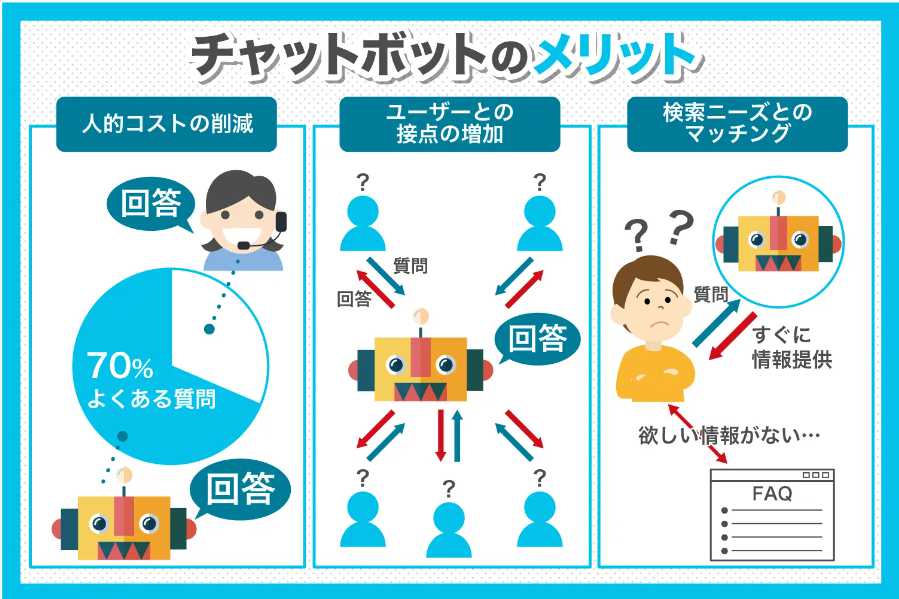

本声明ではチャットボットについて、「『人工知能、自動化されたルール、自然言語処理(NLP)、機械学習(ML)などによってデータを処理し、あらゆる種類のリクエストに対応する』ツールである」と定義。ChatGPTについては「最近リリースされたチャットボットで、『既存の情報を新しい方法で整理して使えるという意味で、これまでにないまったく新しいものを作り出すことができる、生成型AIの一例』である」としている。

そのうえで、現時点で考えられるChatGPTの問題点について、以下のようにまとめている。

・ChatGPTはGoogleと異なり、時事的な情報を求めてウェブをクロールしておらず、その知識は2021年以前に学習したものに限定される。

・チャットボットには意識がないため、既存の素材を繰り返したり、並べ替えたりすることしかできない。チャットボットの発言に新たな思考はなく、偶然にオリジナルになるしかない。

・チャットボットは学習させた既存の文章をライブラリとして利用するため、状況によっては出典を明らかにせずにそのまま繰り返す危険性がある。

・プログラミングによっては、意図的に嘘をつくことができる可能性がある。

・チャットボットは法人ではなく、法的人格を持たないので、チャットボットを訴えたり、裁判所に喚問したり、何らかの形で罰することはできない。

そして、「ChatGPTは、研究者にとっては便利なツールだが、学術雑誌にとっては脅威である。なぜなら、ChatGPTが生成した記事は、出版される文献に誤った内容や盗用された内容を持ち込む可能性があるためだ。ピアレビューでは、ChatGPTで生成されたコンテンツを検出できない可能性がある」と危機感を表明したうえで、ChatGPTをはじめとしたチャットボットと医学論文作成に関する下記の推奨事項を挙げている。

■WAMEの推奨事項(一部を抜粋)

1. チャットボットは論文著者になれない。チャットボットは、著者の役割を理解したり、論文に責任を持ったりすることができないため、著者資格の要件を満たすことはできない。

2. 著者は、チャットボットを使用する場合、透明性を確保し、どのように使用したかの情報を提供する必要がある。

3. 著者は、論文の中でチャットボットが行った作業(発表内容の正確さ、盗用がないことを含む)、およびすべての出典(チャットボットが作成した資料を含む)の適切な帰属に責任を持つ。

4. 編集者は、AIによって生成または改変されたコンテンツを検出するのに役立つ適切なツールを必要とし、これらのツールは支払い能力に関係なく利用できなければならない。

グーグルもChatGPT対抗の独自AIチャットボットをテスト中だそうです(記事をみる)。論文をチャットボットに全部書かせることは当分できないにしても、英文校正などで有効利用しない手はなさそうです。

コメント